Generative AI的安全与隐私挑战

重点摘要

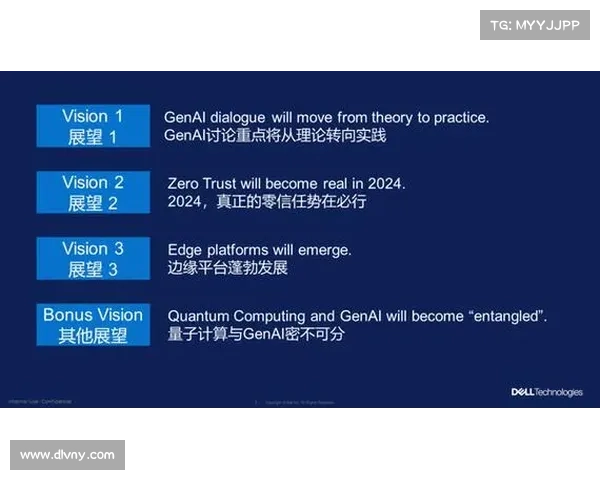

随着生成式人工智能(GenAI)的快速发展和广泛应用,企业在商业化和部署客户应用时面临着前所未有的机会与挑战。近期的数据泄露事件突显出用户敏感数据的安全性问题。本文将深入探讨GenAI工具的独特脆弱性、数据安全的必要措施以及必须开发的新型安全工具。

白鲸加速器下载尽管攻击者尚未开发出专门针对GenAI模型的攻击技术,但诸如OpenAI、微软Recall和三星的数据泄露事件明确表明,GenAI平台可能会导向用户数据的泄露问题。随着组织借助这些工具来提升工作效率,数据安全与隐私的担忧日益增加。因此,了解GenAI产品易受攻击的原因和传统工具是否足以保护数据变得尤为重要。

在评估GenAI产品的脆弱性时,不仅要考虑与其他类型软件的比较脆弱性,还需要关注GenAI工具相较于传统软件的独特脆弱性。传统软件通常是算法驱动的,其可解释性要强于GenAI中使用的模型,这使得理解、调试、测试及修复代码相对简单。然而,消费级AI模型相对新颖,且直到最近,AI研究人员对机器学习模型的安全影响关注不多。

为什么传统工具无法保护生成式人工智能

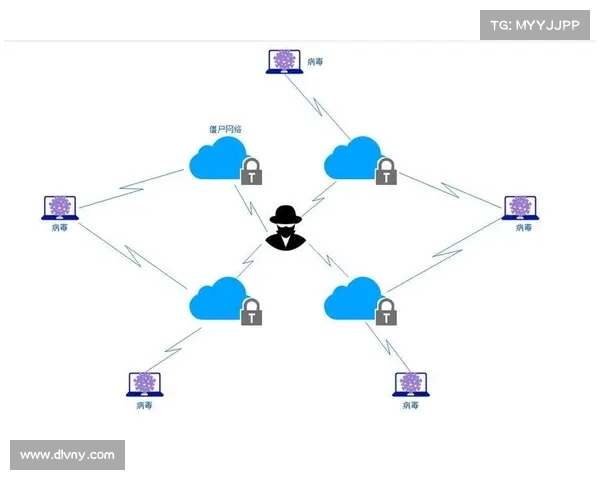

传统的反病毒产品在保护GenAI工具及其数据方面相对无用。虽然在少量情况下,GenAI可能用于编写恶意软件,并可能被反病毒或端点检测与响应(EDR)工具阻挡,但这并不能解决GenAI的主要安全隐忧。必须开发专门的保护措施,比如数据丢失预防(DLP)产品,以限制GenAI能够访问的数据类型,以及防止恶意使用或针对模型的检测和响应能力。

企业领导者需要找出GenAI在公司内部的使用情况。然而,许多组织对其环境中授权和未授权使用GenAI的情况了解甚少,这使他们对于潜在问题感到不安。根据麦肯锡的一项调查,仅有21的使用AI的公司制定了员工使用GenAI的相关政策。

DLP和扩展检测与响应(XDR)工具必须得到开发,以保护数据并检测与GenAI使用相关的安全问题。此外,随着企业采用自己的GenAI工具,他们还需要积极保障这些模型所使用的环境和数据,类似于过渡到云计算时所需的尽职调查。在消费者方面,验证GenAI的安全性可能会变得愈加困难,尤其是随着上游和第三方应用逐渐整合自己的GenAI工具。

关于生成式人工智能的数据隐私关切

有关数据隐私的担忧主要集中在提供商保存了什么数据以及如何处理、保护和匿名化这些数据。不安全的系统可能导致数据泄露,尤其令人担忧的是,GenAI的广泛应用涉及从健康查询到公司知识产权等多个方面。由于GenAI模型需要海量数据进行训练和微调,因此客户数据是否会在未来的模型发布中泄露也是一个合理的担忧。

随着GenAI工具的崛起,组织必须比以往任何时候都更加重视数据安全与隐私。不断变化的攻击态势要求专门针对GenAI所面临的独特挑战,开发额外的保护措施和检测能力。企业必须优先发展强大的安全工具,以有效保护敏感数据并应对与GenAI部署相关的新兴威胁。

Sohrob Kazerounian,Vectra AI的杰出人工智能研究员SC Media观点栏目由SC Media网络安全领域的社区专家撰写,每个贡献都旨在为重要的网络安全主题带来独特的视角。内容力求客观、高质量且非商业化。